液冷时代已到来?

所有电子设备都会产生热量,必须将这些热量移除以确保设备不会过热。几十年来,利用空气流动(风冷)一直是主要的方法,液冷仅限于处理特别高强度的计算工作负载,主要集中在超级计算领域。

随着AI的兴起,数据中心的功率密度已增长到液冷开始大规模建设的程度。目前单相液冷占据主导地位,但两相液冷和浸没式液冷也正作为可选方案不断增长。

这是一种相对较新的现象,主要归因于AI计算导致的功率密度突然飙升。“2000年代或2010年代的计算机处理器功率只有几百瓦,”JetCool创始人兼首席执行官Bernie Malouin指出,“直到最近几年,整体功率水平在很大程度上保持不变。”

“过去,水冷是一种例外情况,”Synopsys产品营销总监Marc Swinnen表示,“那是极端的做法。但现在我很惊讶它变得如此标准。几乎每个高性能系统都采用了水冷。”

液冷有多种形式,并没有单一的最佳解决方案。开发人员不能只是简单地规定使用液冷,他们必须确定哪种类型的冷却方式最好。这一决定对数据中心的基础设施有重大影响,混合搭配不同的冷却方法并不是一个切合实际的选择。

“超级计算行业一直是液冷的先驱,在这里你会看到一块金属板放置在处理器顶部,在许多情况下,如果是HBM(高带宽内存)之类的,也会覆盖内存,”Rambus的研究员兼杰出发明家Steven Woo说,“它内部是中空的,有橡胶管进出。有一个入口和一个出口,液体在一个连续的回路中流动。现在人们正在为浸没式冷却奠定基础。”

任何冷却方案都必须尽早确定,即在架构、性能和功耗进行早期模拟时就需确认。“你必须从一开始就关注架构层面,以确定功耗数值、热通量和冷却方法,”Synopsys SoC工程高级工程师Satya Karimajji表示。

需要明确的是,尽管功率密度推动了向液冷的转变,但这并非为了降低功耗。“这更多是为了在相同的占地面积内传输更多信号,而不是为了降低数据中心的功耗,”Synopsys产品管理总监Rob Kruger观察道。

风冷的问题

大多数数据中心和其他计算场所都依赖风冷。空气进入建筑物,经冷却后被吹入架空地板下方,从而保持室内凉爽。服务器自带的风扇将冷空气推过芯片,空气受热后被吹回大气中。

这个过程在制冷剂中涉及液体,但那远离发生冷却的地方。这也是一个开环系统,引入新空气并排出热空气。这种方法在一定程度上是有效的。但在超过一定的发热水平后,如果不将风扇转速提高到不切实际的程度,它就无法足够快地带走热量,这会导致不安全的噪音水平和其他问题。

“使用风冷时,你需要风扇来吹动空气,气流越快,带走的热量就越有效,”西门子EDA创新路线图经理Robin Bornoff说,“但这有一个极限。风扇越大,服务器就必须越大,从而降低了计算密度。”

水是比空气更有效的冷却剂,尽管它通常不单独使用。“它的密度约为空气的1000倍,”Bornoff说,“它的热导率是空气的20倍。与空气相比,用水可以提取更多的热量。”

这带来了更强的散热能力,将液体泵送到热交换器可以将热量从电路中带走。最终,这些热量会加热空气,但这发生在其他地方,远离服务器机架。

冷却芯片的三种方式

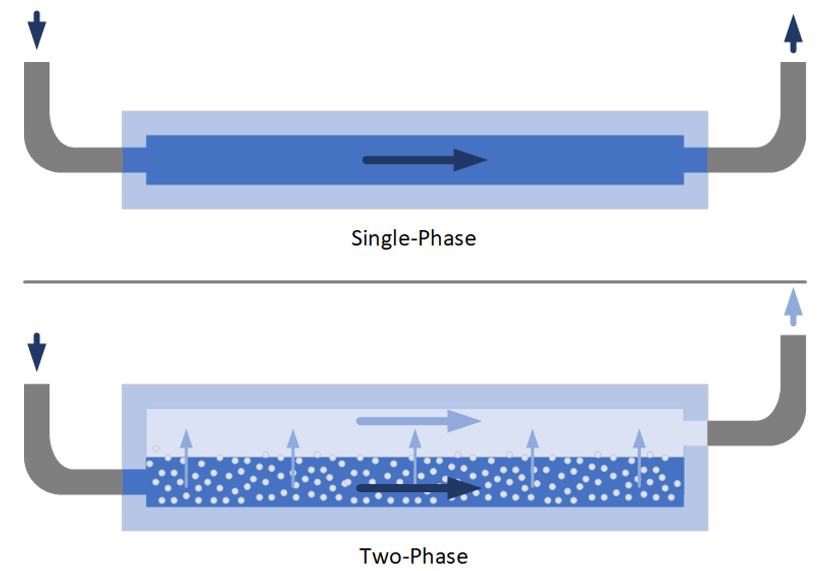

液冷有三种可能的形式。目前最常见的是单相液冷,因为冷却液始终保持液态。该系统依赖于液体比空气更高的热导率和热容来完成更有效的工作。

目前不太常见但研究力度很大的是两相液冷。其目的是利用从液体变为气体所需的巨大潜热。“相变吸收的热量实际上比从0°C到100°C的温度变化吸收的热量还要多,因此它在散热方面非常高效,”Swinnen说。与单相不同,这里的冷却液实际上会沸腾,带走的热量远超单相冷却所能达到的水平。

冷板中单相与两相冷却的概念图。在单相冷却中,冷却液保持液态并在CDU(冷却液分配单元)中冷却。在两相冷却中,冷却液沸腾,蒸汽被移除并重新冷凝,从而带走更多热量。

“沸腾是个绝妙的主意,”Bornoff说,“这是一种非常有弹性的散热方法,但它也有其局限性。”

即使液体沸腾,保持其与受热表面的接触也很重要。“最终表面上会有一层几微米厚的水,”Bornoff说,“热量进入那少量液体中,然后传递给气泡。气泡消失,被新的液体取代。只要气泡形成且它们之间有一些液体,那就是最大的热传递效率。”

如果热通量太高——即每单位面积散发的热量太快,而系统无法跟上,那么底部的这层水也会蒸发。在这种情况下,就没有液体与热源接触了。取而代之的是水蒸气,这是一种气体——本质上又回到了风冷。此时冷却效果会急剧下降。这种热通量水平被称为临界热通量(CHF)。

第三种液冷方法是全浸没式。它涉及一个装满液体的槽,整个服务器都浸没其中。这种液体必须是介电的(绝缘的),以防造成短路。它还必须无腐蚀性,以保持电子设备的完好。浸没式可以作为单相或两相冷却系统运行。

在这种情况下,液体仍然被泵出进行冷却。最初,建筑物内的一个单泵将冷却液分配到各处,但这因管道损耗等原因被证明效率低下。现在,液冷槽配备了更近的再循环器——有时被称为节能器,因为它们的运行效率更高。

浸没式冷却从所有组件中带走热量,但其速度比其他技术慢。“如果标准是热量捕获的百分比,浸没式做得非常好,”Malouin说,“你可能会将服务器近100%的热量捕获到流体中。但由于流体本身的热特性,用单相浸没式冷却数千瓦的设备真的很难。”

应用液体的不同方式

浸没式冷却的工作方式大同小异,但其他方法有一些变体。目前最常见的实现方式是冷板,它贴附在芯片封装上,取代了以前风冷用的散热器。

“我在展会上看到最常见的东西是某种有液体流入的板,”Rambus的Woo观察到,“板接触重要的半导体元件,通常有引导液体流动的凹槽。”

冷板的优点是它是一个独立的单元,可以在组装时安装到封装上。它不会影响封装内部的裸片、芯粒或其他组件。

冷板的缺点是冷却液通过封装顶部、界面材料和冷板底部与芯片隔开。主要的热传递要么向下通过PCB,要么向上通过冷板。除了焊料和金属线,中间的材料并非因其热导率而被选中,这在冷板和封装内容物之间留下了障碍。

除冷板之外,还有一种被称为直接喷射或直接液冷(DLC)的技术,意味着冷却液直接接触被冷却的裸片。冷却液可以流过或喷射到硅片背面。因为冷却液直接接触裸片,它能立即接触热源并更迅速地带走热量。

挑战在于冷却液必须与封装的其余部分隔离,这目前还不是一个完全解决的问题。包含多个裸片的先进封装提出了另一个挑战。如果一个裸片是主要热源,那么冷却可以只集中在该裸片上。但如果有多个高功率计算芯粒,每个都需要单独冷却。目前有大量的研究正在进行,但大规模应用才刚刚起步。

冷却液很重要

人们很容易认为水是显而易见的冷却剂,但更常见的是水和丙二醇的混合物(通常是50/50),这种组合简称为PGW。丙二醇类似于汽车防冻液(乙二醇)。像防冻液一样,它扩展了冷却剂保持液态的温度范围。防冻液仅描述了冷却剂在低温端的作用。然而,汽车类冷却液具有剧毒,通常仅用于人类不太可能误食的地方。

丙二醇毒性较小,但在1个大气压下,其沸点约为188°C,低于乙二醇的197°C。与水50%混合后,这些限值降至约105°C和108°C,虽然比水高,但也高不了多少。

对于浸没式冷却,介电冷却液的设计既要有效,又要对人类和电子设备友好。旧的液体可能有毒,但现代液体被选择为无毒、无腐蚀性、不易燃且可生物降解。而且现代冷却液比PGW更贵。

“浸没式冷却使用了一些有趣的液体,”Woo说,“它们是电惰性的。我把手放进去——一家公司让我这么做——我甚至感觉不到,因为它们不发生反应。它们也不与你的皮肤反应,所以感觉很奇怪。”

加热后的冷却液带来了一个意想不到的潜在好处。与散失到大气中的热空气不同,液体在一个封闭系统中运行。“[液体]流入流出机箱,然后进入热交换器,在那里交换热量,冷却下来,并循环回服务器,”Woo说。

这意味着冷却液内部的热量可以用在其他地方。一项已进行初步研究的想法是将冷却液通过管道输送出数据中心,为附近居民产生热水。这使得计算消耗的部分能源得以回收和再利用。

“液体的优点是能量被倾倒在液体中,这是一种非常有效的存储本来会损失的能量的方式,”Bornoff说,“为什么不把它泵入当地的生活热水回路,以满足附近住宅的热水需求呢?”

环境因素也很重要。“你要确保液体中不含‘永久性化学物质’,”Woo指出。

基础设施变革

从风冷转向液冷不仅仅涉及芯片、服务器和机架层面的变化。除了极少数例外,整个数据中心都必须配备处理液体的设施。

“你需要泵和软管,”Woo说,“你需要考虑可维护性。有高可靠性、低泄漏的阀门,可以从服务器上快速开关。它们还有热交换器。对于浸没式,你谈论的是直接在循环系统中的槽。”

如果整个机架或一排机架采用液冷,那么就不再需要架空地板。取而代之的基础设施是管道和液体处理系统,通常通过冷却液分配单元(CDU)进行泵送。

“其中一些数据中心内部的管道设计非常有想象力,”Synopsys的Kruger指出。

管理这些系统不同于现有的风冷方法。“两个指标很重要:低压降和低热阻,”Alloy Enterprises联合创始人兼首席执行官Ali Forsyth说,“这允许数据中心在循环更高温度的水的同时,仍能满足机架内组件的热需求。这意味着不需要制冷或提升暖通空调(HVAC)功率,这是巨大的能源节约。”

每种冷却方法都有其自己的基础设施。因此,一个机架——甚至整个数据中心——通常会致力于一种冷却类型。“你通常不会看到一个托盘是液冷的,而其他的却是风冷的,”Forsyth观察道。

冷板

冷板可以根据封装尺寸定做。然而,这忽略了一个事实,即热量并不是在整个封装中均匀产生的。如果封装容纳单个裸片,该裸片表面的不同区域会有冷热之分。而包含多个组件的先进封装将包含一些比其他组件产生更多热量的组件。

因此,一些冷却解决方案涉及定制冷板,将冷却集中在产生热量最多的地方。Alloy Enterprises采用3D打印技术在冷板内部创建定制的液体路径。其最常用的冷却液是含25%水的丙二醇。

“我们开发了一种称之为叠层锻造的制造工艺,这是一种基于板材的工艺,我们可以在单件组件中制造复杂的内部和外部几何形状,”Forsyth说,“我们可以在需要的地方放置大通道,对其进行适当的尺寸调整和优化。我们在需要的地方放置小尺度通道。”

与其从必须烧结的粉末开始,其工艺通过堆叠多个金属层来构建冷板。内部表面使用激光进行图案化,以创建引导液体的凹槽。可以有多个冷却液入口以提高冷却效率。

“几乎所有的3D打印都在某个时刻依赖于熔化或熔融金属,或者某种形式的烧结,”Forsyth解释说,“当你有液态金属时,制造微小的东西真的很难。通过毛细作用力,它会渗入那些小孔中。因此,我们能够制造出比其他金属3D打印工艺小一个数量级的通道尺寸。”

高温制造步骤提供扩散键合,将各个板材结合成单块金属。该工艺避免了典型金属3D打印可能出现的翘曲。“所有东西同时加热,因此我们不会因热梯度而引入残余应力,”Forsyth说。

另一家公司HydroGraph进行了一些两相实验,在冷却表面沉积材料,以防止表面过于光滑导致过热。它在沸腾表面创建了铜上烧结镍、多孔铜/镍界面以及其专长的石墨烯。增加的粗糙度提供了成核点,与裸铜相比,热传递系数(HTC)提高了152%,临界热通量(CHF)比裸铜高40%。

来个冷水澡

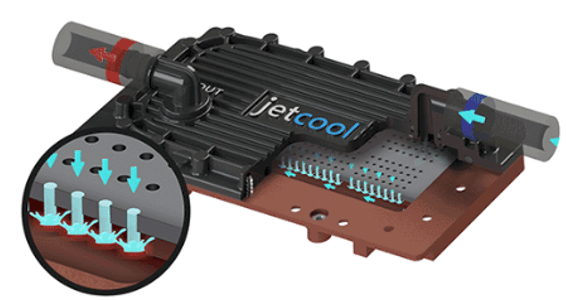

直接喷射冷却的一个例子来自JetCool,其装置带有微小喷嘴,可将冷却液喷射到表面上。该公司有三种提供该技术的方式——直接喷射到硅片上,这是最先进的配置,最适合最高功率;作为冷板;以及作为用于缺乏液体基础设施的机架的独立单元。它声称正在冷却功率高达5000瓦的芯片。

JetCool的直接液冷。液体流入最右侧的端口(蓝色箭头),并被压入喷嘴(中间和插图)。热液体从左侧端口流出(红色箭头)。

独立型号可以替代现有服务器中的风扇,降低高达15%的功耗。“这些通常是位于服务器内部的小型液冷回路,”Malouin解释说,“这允许我们的客户在任何风冷数据中心部署液冷。这可以将服务器功耗降低15%。”

就像Alloy的凹槽经过图案化以匹配热点一样,JetCool的喷嘴也是针对每个封装定制位置的。

一些DLC系统可能使用高压。“根据我们看到的客户结果,喷射冲击的压降有40倍的差异,”Forsyth说。

然而,JetCool表示他们不是这样做的。“我们在给定的流体动力预算下可以实现更好的性能,因为我们特别不依赖压力来驱动性能,”Malouin说,“通常,我们将压降降至最低,因为当最大化流动强度而不是压力时,我们的技术效果最好。”

没有唯一的正确答案

该领域的参与者认为,这些解决方案中的每一个都有其最佳应用点(sweet spot)。没有任何一种会彻底淘汰其他方案。虽然冷板最简单且成本最低,但DLC可以为高功率芯片最快地带走热量。浸没式可以带走更多的总热量,因为它冷却所有东西,而不仅仅是某些芯片,尽管它冷却高功率芯片的速度可能不如DLC快。

“随着当今计算的多样化,所有这些不同类型的冷却在市场上都有一席之地,因为不同的工作负载、不同的应用以及不同的部署风格和位置都有不同的要求,”Malouin说。

在替换现有风冷基础设施时,增加液体基础设施是一个障碍,但对于新建项目来说障碍较小,尽管JetCool的独立单元是避免重建基础设施的一个选择。该投资的部分回报是有能力构建包含无法仅靠风冷冷却的芯片的服务器,从而增加所用服务器和机架的价值。

如果数据中心计划转向高压直流(HVDC),即把更高的直流电压一直输送到机架,然后再降压到可用水平,那么该项目也可能是转换冷却基础设施的好时机。

“多个巨大的变化正在同时发生,”Woo指出,“人们正在谈论400V配电,甚至800V。如果你正在考虑配电方面的重大变革,也许可以将其与冷却升级结合起来。”

可维护性也很重要。输送冷却液的管道必须放置妥当,以便在必要时仍能接触到服务器本身。“可维护性可能更具挑战性,因为可能需要移开管道才能更换组件,”Malouin指出。

浸没式冷却带来了更大的维护挑战。移除单个服务器可能是可行的,但也可能需要排空介电冷却液,之后再重新加注。“浸没槽必须打开,这可能会影响除正在维修的系统之外的多个系统,”Malouin补充道。

通常,必须进行浸没监测以检测任何过热情况,并重新平衡工作负载以控制温度。

新型冷却即将上线

单相冷板和浸没式冷却目前的使用还很有限,但随着公司建设能够处理AI训练和高性能计算的数据中心,冷板可能会变得更加普及。英伟达的Grace/Blackwell机架已经包含了液冷,并且支持液冷的机箱已在市场上销售。

“如果你去SuperMicro这样的地方,你可以买到带有液冷的机架,”Woo说,“它们是4U的盒子,上面2U是英伟达或AMD引擎,下面2U是双插槽Xeon或EPYC处理器。如果你去SuperMicro网站,你会看到带有液体管道的机箱。”

冷板的提供方式可能有所不同。“有时冷板随芯片本身出售,”Forsyth说,“在其他情况下,超大规模云厂商或服务器制造商会购买芯片、TIM(热界面材料)和冷板,并自行组装。”

直接冷却开始变得可用,两相冷板应该会在几年内出现。一旦转型完成,液冷应该不再让人感觉是负担,因为机架将为此配备齐全。

浸没式冷却的使用大概率会增加,但这比冷板或DLC更费周章,可能会被更具选择性地采用。

在可能的情况下,对于处理更普通用途、功率更适中的硅芯片的机架,风冷可能仍将受到欢迎。液冷的运营成本可能较低,但基础设施投资必须有合理的盈亏平衡期,这种转换在经济上才有意义。

因此,数据中心的未来可能包括风冷、冷板、DLC和浸没式的混合。这种混合将包括单相和两相系统。单个数据中心可能只配置一种冷却类型,但这种混合预计将存在于各类数据中心之间。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。