数据中心热管理中两相D2C冷却成本分析

随着人工智能工作负载的不断扩展,尤其是在NVIDIA GB300、G200和H200服务器等高GPU密度平台的推动下,散热管理已成为数据中心基础设施中最关键、成本最高的环节之一。专为高端人工智能应用设计的机架功率密度如今已普遍超过100千瓦,远远超出传统风冷的实际极限。这种转变正在加速直接芯片冷却(D2C)技术的普及,尤其是两相冷却方案,这些方案正日益被视为必不可少而非可选项。

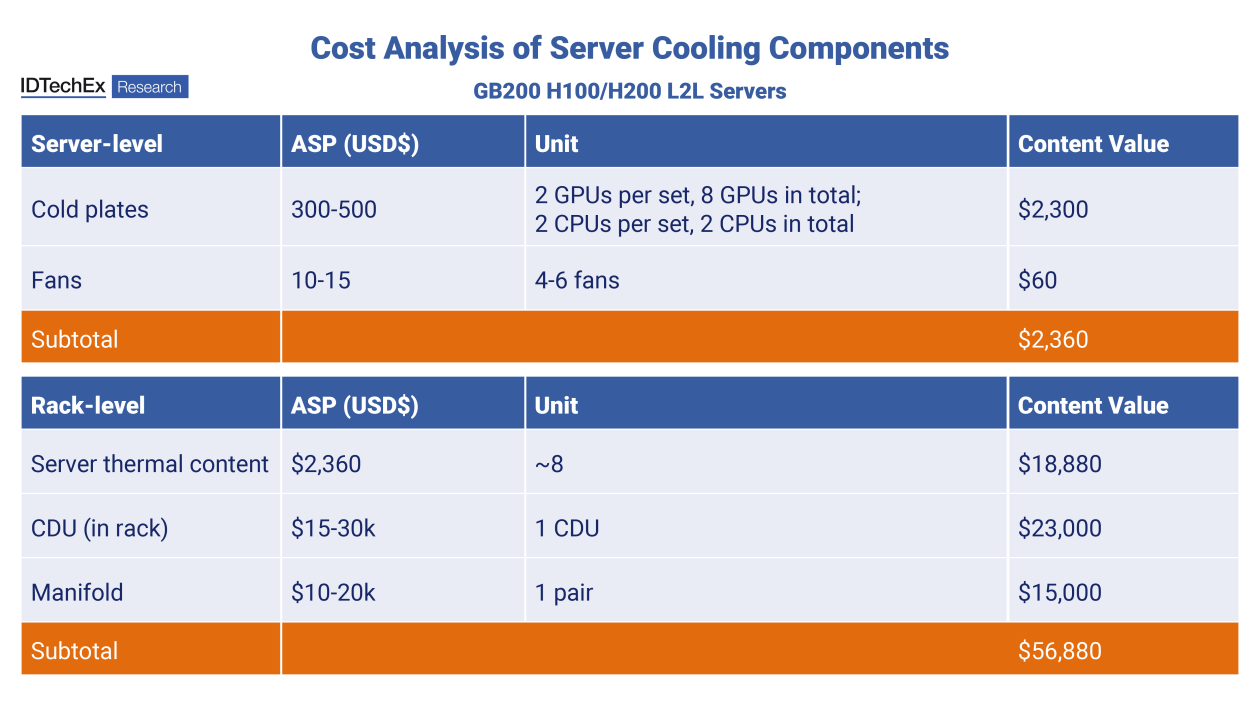

服务器散热组件的成本分析凸显了一个重要事实:虽然冷板通常最受关注,但它们仅占整个散热系统成本的一小部分。只有将服务器级散热成本汇总到机架和机房层面,才能真正了解其经济效益。

服务器级成本

据IDTechEx估计,服务器级冷板的平均售价约为每块300至500美元,具体价格取决于冷板是用于CPU还是GPU。由于GPU冷板的热通量更高,散热设计要求也更苛刻,因此其价格通常高于平均水平。值得注意的是,GPU冷板只能使用铜材。铝材虽然更便宜、更轻,但在液冷回路中与其他金属混合使用时,尤其是在长期使用后,会产生不可接受的电偶腐蚀风险。

以一台典型的8GPU AI服务器为例,冷板的成本约为2300美元,这不仅包括冷板本身,还包括整个芯片级直冷系统的成本。如果按芯片计算,直冷系统的价格通常在每芯片200至400美元之间,这与文中描述一致。CPU冷板的价格往往偏低,而GPU冷板的价格则偏高。

需要强调的是,冷板系统的成本构成远不止加工成型的铜块。软管、接头、服务器内部的流体分配歧管,尤其是快速接头(QD),都会显著增加成本。快速接头之所以成为成本的主要驱动因素,是因为它们需要精密加工、完全密封,并且随着流量的增加,其直径也会增大。虽然单个冷板看起来相对便宜,但对于GPU密集型服务器而言,所需的快速接头的数量和尺寸会迅速推高系统成本。

相比之下,风扇的成本几乎可以忽略不计,每台服务器大约 60 美元,而且风扇的作用越来越次要,主要用于非液冷组件的残余空气冷却。

从服务器到机架:成本倍增效应

当服务器级散热成本扩展到机架级时,经济效益就显而易见了。假设每个机架大约有八台人工智能服务器,那么仅服务器散热成本就高达每个机架约 18,880 美元。但这仅仅是个开始。

机架级基础设施会大幅增加成本。安装在机架内的冷却液分配单元 (CDU) 的平均售价通常在 15,000 至 30,000 美元之间,IDTechEx 估计其代表性价值为 23,000 美元。此外,用于管理服务器间流体输送和回流的歧管也会增加 10,000 至 20,000 美元的成本,即每个机架约 15,000 美元。

综合来看,机架级散热总成本接近 56,880 美元,这凸显了冷却基础设施已发展成为与计算机硬件本身同等重要的资本密集型子系统。这种转变对数据中心设计、供应商选择和长期总拥有成本 (TCO) 都具有重大影响。

冷却组件成本分析。资料来源:IDTechEx,《数据中心热管理 2026-2036》

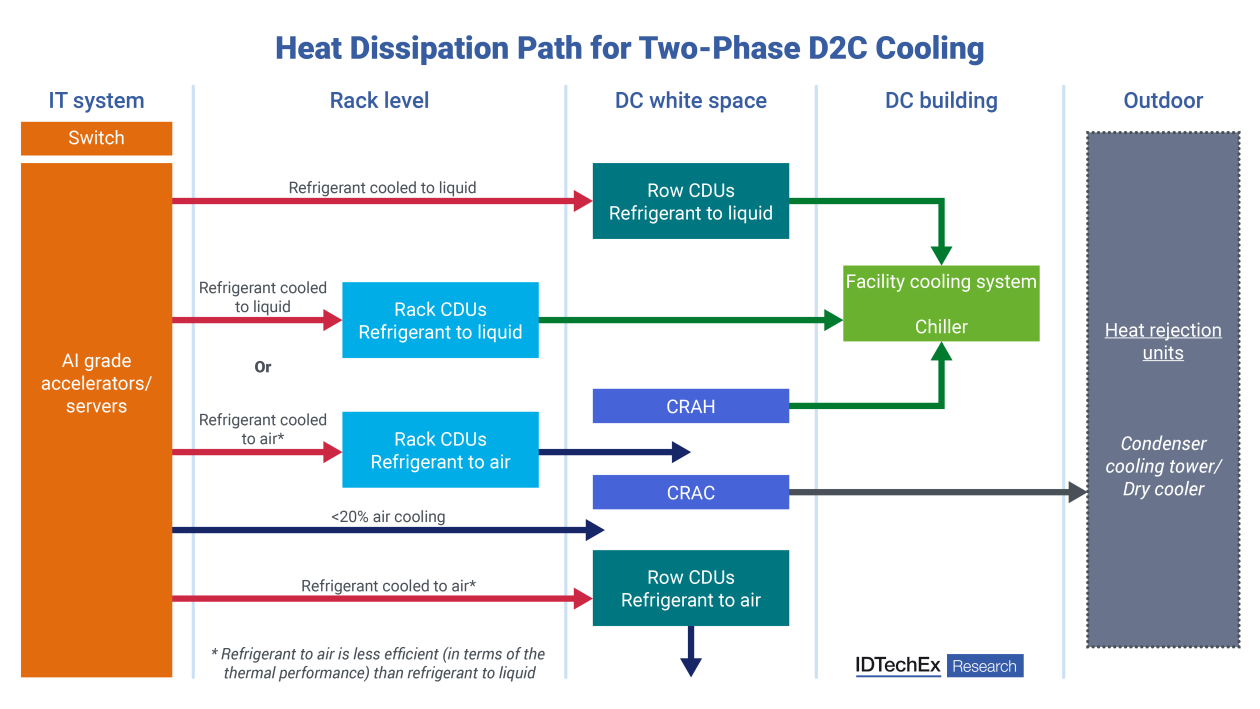

两相D2C冷却:热流超出机架

第二张图展示了两相D2C冷却的散热路径,突显了热管理远不止于服务器机箱内部。AI加速器产生的热量直接被芯片吸收,制冷剂在芯片表面发生相变,从而高效地带走大量热能。

两相D2C冷却散热路径概述。来源:IDTechEx,《数据中心热管理2026-2036》

由此出发,存在几种设计路径:

- 机架式 CDU(制冷剂到液体)将热量传递到设施水循环系统中,然后输送到冷水机组,最终输送到室外散热装置,例如冷却塔或干式冷却器。

- 行级 CDU 可聚合多个机架,提高效率并减少设备重复。

- 在混合配置中,仍有一小部分(通常<20%)的余热可以通过CRAH或CRAC单元进行空气冷却来处理,尽管在下一代AI数据中心中,这种情况正变得越来越少。

两相制冷剂-液体冷却方案通常比制冷剂-空气冷却方案热效率更高,但需要更复杂的管道和控制系统。图表清晰地表明,冷却不再局限于数据中心的“IT侧”,而是与制造层面和基础设施紧密相连。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。