从GPU到内存池,为什么AI需要CXL

CXL 3.0 允许整个服务器机架作为统一、灵活的 AI 结构运行。这对于传统 GPU 孤岛受内存限制的 AI 工作负载尤其重要。

人工智能(AI) 正在进入一个前所未有的规模时代。从训练万亿参数的大型语言模型 (LLM) 到实现实时多模态推理,AI 工作负载正在重塑数据中心基础设施的根基。虽然 GPU 和加速器已成为 AI 的门面,但幕后仍存在一个关键瓶颈:内存、带宽、延迟和可扩展性挑战往往决定着 AI 系统的成败。Compute Express Link (CXL) 应运而生,提供变革性的解决方案。

人工智能的内存瓶颈

以下是造成人工智能内存瓶颈的一些关键因素:

- 训练基础模型需要巨大的内存容量,通常超过单个 GPU 的可用内存容量。

- 大规模推理需要快速访问大型数据集,而无需在 GPU 之间复制内存。

- 传统架构迫使 CPU、GPU 和加速器各自独立运行,导致效率低下。

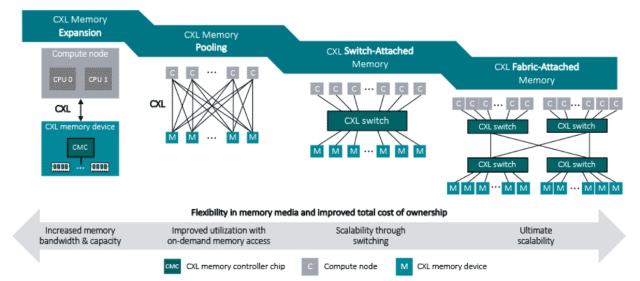

图 1.传统孤立内存(CPU、GPU 岛)与支持 CXL 的池化内存的比较图(来源:Rambus)

如图 1 所示,在孤立架构中,每个 CPU 或 GPU 都绑定到各自独立的内存,这通常会导致容量利用率不足。借助 CXL 池化,所有处理器都可以访问统一的共享内存空间。这种转变能够实现灵活的扩展、更高的利用率以及 AI 和数据密集型工作负载的性能提升。

CXL如何提供帮助?

Compute Express Link (CXL) 是一种开放的行业标准互连,旨在满足现代工作负载日益增长的性能和可扩展性需求,尤其是在人工智能和高性能计算领域。与针对通用 I/O 进行优化的 PCIe 不同,CXL 专门设计用于连接 CPU、GPU、加速器和内存设备,实现低延迟和完全缓存一致性,确保数据在异构处理器之间保持同步。通过超越传统的设备到主机通信,CXL 实现了统一的结构,使计算和内存资源可以在整个系统甚至服务器集群之间无缝共享。

CXL 引入的最具影响力的功能之一是内存池,它允许根据工作负载需求将内存动态分配给不同的设备,而不是静态地绑定到单个 CPU 或 GPU。这消除了闲置容量,并提高了内存资源的利用率。另一个关键特性是分层内存,其中高性能本地 DRAM 可以通过更大的 CXL 连接内存池(例如 DDR5 或持久内存)进行补充,从而实现速度、容量和成本效率的平衡。最后,CXL 是可组合基础设施的基石,其中计算、加速器和内存等资源可以实时组装和重新组装,以满足不断变化的工作负载需求,从训练海量大型语言模型到运行延迟敏感的推理任务。

简而言之,CXL 代表着从静态、孤立的架构向灵活的基于结构的计算的转变,为下一代人工智能和数据密集型系统铺平了道路。

为什么 CXL 对 AI 基础设施很重要

1. 大型语言模型 (LLM) – CXL 支持跨节点内存池化,减少了昂贵的内存复制需求。

2. 多 GPU 推理——共享内存池简化部署并降低基础设施开销。

3. 可组合 AI 数据中心——CXL 允许灵活扩展,而不是过度配置内存。

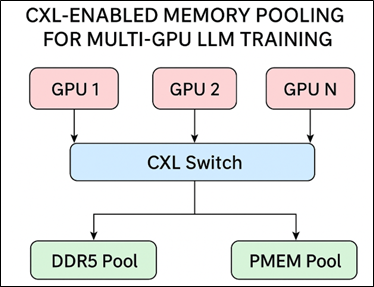

图 2.流程图展示了内存池如何支持多 GPU LLM 训练。

如图 2 所示,CXL 内存池允许多个 GPU 共享统一的内存池,从而实现大型语言模型的高效扩展。

未来之路:CXL 3.0 及未来

随着 CXL 3.0 的推出,业界正从渐进式改进迈向数据中心架构的根本性转变。通过引入结构拓扑、多级交换和跨主机的一致性内存共享,CXL 3.0 使整个服务器机架能够作为统一、灵活的 AI 结构运行。这对于大型语言模型等 AI 工作负载尤为重要,因为传统的 GPU 孤岛受制于内存限制,被迫进行复杂的模型并行处理。由于 GPU 之间可以访问共享、一致的内存池,训练速度更快,重复工作减少,并且可以更高效地支持更大的模型。超大规模数据中心、云服务提供商和高性能计算 (HPC) 设施已开始试行支持 CXL 的部署,从英特尔、AMD 到三星和 HPE 等供应商都已将支持纳入其路线图。展望未来,CXL 预计将朝着更快的互连、更细粒度的可组合性以及针对池化内存原生优化的 AI 框架的方向发展。

总之,CXL 3.0 是一个转折点——从以服务器为中心的计算到以结构为中心的 AI 基础设施——为下一代可扩展的 AI 和 LLM 系统奠定了基础。

CXL 提供缺失的环节

AI 的未来不仅仅取决于 GPU,它需要重新思考内存的连接、共享和扩展方式。CXL 填补了缺失的环节,将孤立的资源转化为一致、灵活的 AI 基础架构。对于 AI 基础架构社区而言,CXL 不仅代表着技术,更代表着构建下一代数据中心的基础。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。