异构运算,CPU/GPU/NPU各有所长

生成式人工智能技术及大型语言模型逐步往终端应用拓展,在边缘端导入生成式AI的愿景,已成为处理器厂商竞相争夺的领域。面对市场上特定应用领域的AI推理需求,处理器厂商积极开发适用于终端设备的解决方案,期望未来终端应用能够引入生成式AI。

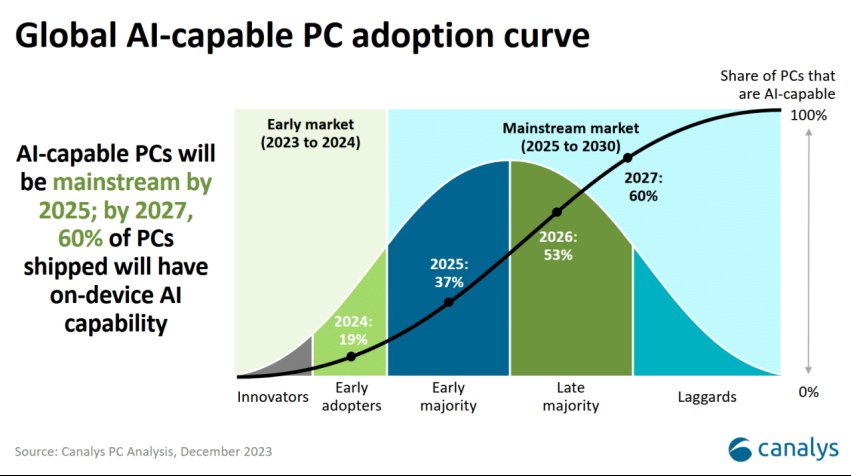

处理器厂商在CPU中引入AI引擎,并通过整合CPU、GPU与神经处理单元(NPU),提高AI设备的性能,并降低功耗,持续为LLM走向边缘铺路。AI PC与AI手机相继问世,也受到市场高度关注(图1)。

图1 全球AI PC采用曲线(图片来源:Canalys)

图1 全球AI PC采用曲线(图片来源:Canalys)

CPU导入AI引擎

AMD工业、视觉、医疗与科学市场机器人业务主管KV Thanjavur Bhaaskar(图2)指出,CPU一直是功能强大的通用计算引擎,相较于其他计算平台,在支持的广泛软件生态系统方面具有优势。随着边缘AI的快速发展,近年来的趋势是CPU除了通用计算和图形处理功能外,还配备了专用的AI计算引擎。

目前为止,设计人员必须在设计中引入加速器,才能实现高性能的AI推理。将专用的AI计算引擎集成到CPU中,提供灵活的架构选择,减少占地面积并提高能源效率。

就新兴应用而言,边缘AI已无处不在,因此过去仅搭载CPU的设备,现在也开始具备AI功能。例如,具有AI路径规划的机器人控制器、具有诊断或感兴趣区域(Region of Interest)功能的医学影像等。市场上持续开发的边缘AI产品,产品设计主要根据产品需求,选择适合的处理器。因为计算工作负载的多样性、处理器有效处理计算的方式,以及系统中的计算能力可用性都有显著的变化。

异构计算平台不可或缺

AMD工业、视觉、医疗与科学市场视觉业务主管Yingyu Xia(图3)指出,为了支持嵌入式设备上的生成式AI模型,处理器必须具备异构计算平台以及一个编译器,能够高效地在应用处理器(PS)、GPU、NPU和现场可编程门阵列(FPGA)之间分配各种工作负载。此外,平台应该配备软件开发工具包(SDK),帮助嵌入式工程师将其模型无缝部署到硬件平台上。

其中,FPGA有助于整合多种传感器模态,以利用多模态模型并确保传感器同步。此外,FPGA的可编程设计,有助于建立定制化且最优化的数据路径,从而实现系统组件之间的有效数据传输。随着AI模型及其参数的复杂性日益提升,系统内部的数据高速传输机制需求也在增长。

AI PC灵活应对AI需求

在AI PC应用中,英特尔(Intel)即整合CPU、GPU与NPU,通过xPU的概念,期望终端设备能够灵活应对不同的AI计算需求。英特尔网络及边缘计算事业群平台研发协理王宗业(图4)表示,LLM需要大量的计算能力,针对不同工作负载的计算需求,可以采用不同的处理器来增强计算和节能效率。以图像识别应用为例,在图像识别完成后,用户可能需要搜索数据库。由于CPU的用户界面成熟,因此数据库搜索的工作建议通过CPU执行。

而GPU与NPU都具有较高的计算能力,区别在于GPU的技术较为成熟,因此适合应用在短时间且算力需求极高的应用。NPU则在生成式AI导入边缘的过程中,在低功耗与高算力的需求下应运而生。因此,例如在线会议的背景消除功能,因为需要长时间运行,适合通过NPU执行,以达到计算性能足够且功耗较低的目标。

NPU颠覆处理器市场

耐能智慧董事长刘峻诚认为,NPU的推出对处理器产业具有划时代的意义。在生成式AI应用兴起之后,LLM计算所需的大量电力与算力,导致企业训练AI的成本大幅上升,小型企业或个人难以训练定制化的AI模型。NPU采用可重构芯片架构,通过脑神经元的多点连接特性,核心数可以达到上千,甚至上万个。因此,NPU有利于在低功耗的前提下,支持Transformer模型的加速计算。

NPU不仅执行AI计算的效率高,而且计算功耗远低于GPU,有效降低了GPT模型的训练成本。在应用方面,耐能通过在笔记本电脑中引入NPU,建立了离线版的GPT聊天机器人。同时,耐能开发小型服务器,为个人或企业提供上传内部文档,建立定制化的GPT聊天机器人的服务。

采用NPU的终端设备打破了GPU执行AI计算时常见的散热瓶颈。上述的小型服务器与笔记本电脑,在GPT启动时,即便没有安装风扇,设备也不会发热。曾有GPU平台在引入NPU后,性能提升40%,并且热能减少30%。可见NPU有利于边缘AI设备在算力增加的同时,降低发热与功耗。

定制化模型将成为主流

长远来看,未来边缘生成式AI将会满足更多的定制化需求,并与预测式AI整合,实现优势互补。王宗业分析,每个企业对AI的需求都不同,因此生成式AI将走向定制化模型。其次,LLM将进入多模态的运作模式,除了文字,还可以生成声音、图像等多种信号。

边缘生成式AI的第三个发展方向,是走向多代理(Multi-Agent)与多模型(Multi-Model)的阶段。现阶段的生成式AI是通用式应用,而多代理(Multi-Agent)指的是每个AI模型都是特定领域的专家,每次使用语言模型时,只需要将相关领域的专家模型放在一起进行推理。在此趋势下,边缘AI也将需要更大的计算能力与更多的内存支持,才能同步执行多个专家模型。

最后,在生成式AI之前,预测式AI技术已经发展成熟,生成式AI执行某些任务的精确度可能比不上预测式AI。因此可以预期预测式AI及生成式AI将走向整合,结合两者的优势,以满足AI的应用需求。

AI PC通过整合CPU、GPU与NPU的异构计算平台,强化终端设备的AI计算性能,同时控制设备的功耗。NPU的推出,为边缘LLM带来了全新的机遇。其高性能、低功耗的特性,实现了边缘GPT,为企业所需的定制化语言模型带来了全新机遇。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。