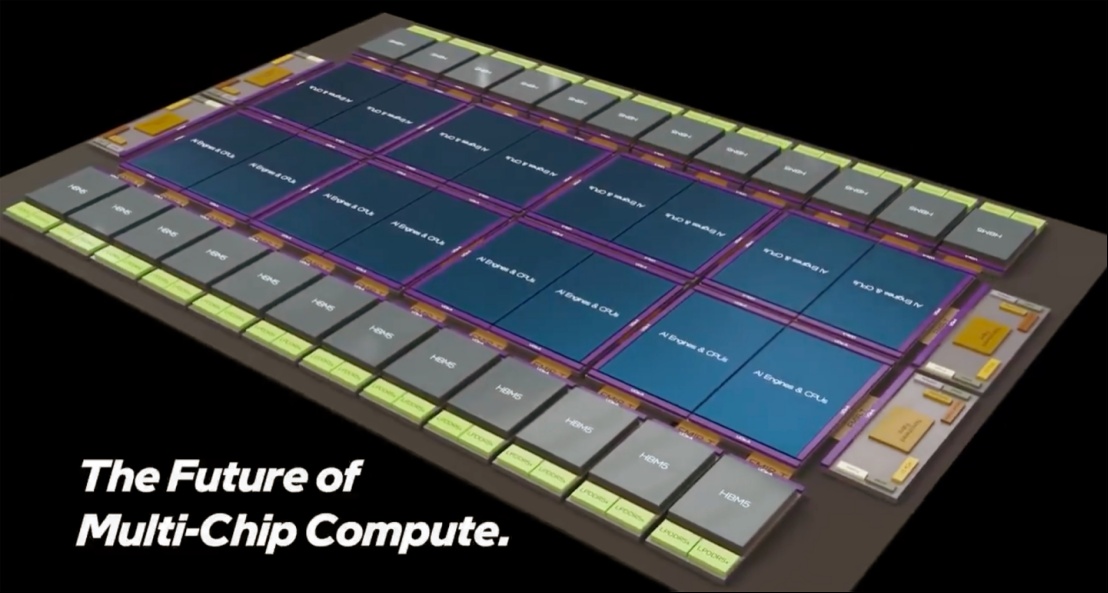

16计算单元+24颗HBM5!英特尔展示超大型多芯片封装技术

英特尔率先打造了由 47 个芯片组成的显式解耦式芯片设计,其面向人工智能和高性能计算应用的 Ponte Vecchio 计算 GPU 便是其中之一。该产品至今仍保持着多芯片设计数量最多的纪录,但英特尔晶圆代工计划推出一款更为极致的产品:一款多芯片封装,在八个基本芯片上集成至少 16 个计算单元、24 个 HBM5 内存堆栈,其尺寸可扩展至市面上最大 AI 芯片的 12 倍(光罩尺寸为 12 倍,超过了台积电的 9.5 倍)。当然,如此强大的处理器需要怎样的功耗和散热?

来源:英特尔

英特尔的概念性 2.5D/3D 多芯片封装展示了 16 个大型计算单元(AI 引擎或 CPU),这些单元采用英特尔 14A 甚至更先进的 14A-E 工艺技术(1.4nm 级、增强功能、第二代 RibbonFET 2 环栅晶体管、改进的 PowerVia Direct 背面供电)制造。

这些芯片位于八个(大概是光罩大小的)计算基础芯片之上,这些芯片采用 18A-PT 工艺(1.8nm 级,通过硅通孔 (TSV) 和背面供电增强性能),可以执行一些额外的计算工作,或者为“主”计算芯片提供大量的 SRAM 缓存,正如英特尔在其示例中所展示的那样。

从尖端互连技术到系统级组装和测试,英特尔晶圆代工提供下一代多芯片平台所需的规模和集成度。

技术与计算单元连接,利用超高密度 10 微米以下铜对铜混合键合技术,为顶层芯片提供最大带宽和功率。英特尔的 Foveros Direct 3D 技术目前是英特尔晶圆代工封装创新的巅峰之作,彰显了其精湛的设计。基础芯片采用 EMIB-T(增强型嵌入式多芯片互连桥,带有 TSV),顶部采用UCIe-A,用于彼此之间以及与采用 18A-P(1.8nm 级,性能增强型)和定制基础芯片制造的 I/O 芯片之间的横向(2.5D)互连,最多可支持 24 个 HBM5 内存堆叠。

值得注意的是,英特尔提议使用基于 UCIe-A 的 EMIB-T 接口来连接定制的 HBM5 模块,而不是使用符合 JEDEC 标准的、采用行业标准接口的 HBM5 堆栈,这可能是为了获得更高的性能和容量。鉴于此次演示的性质,使用定制的 HBM5 堆栈并非设计要求;这仅仅是为了展示英特尔也能够集成此类器件。

整个封装还可以容纳 PCIe 7.0、光引擎、非相干结构、224G SerDes、用于安全等的专用加速器,甚至还可以容纳 LPDDR5X 内存以增加 DRAM 容量。

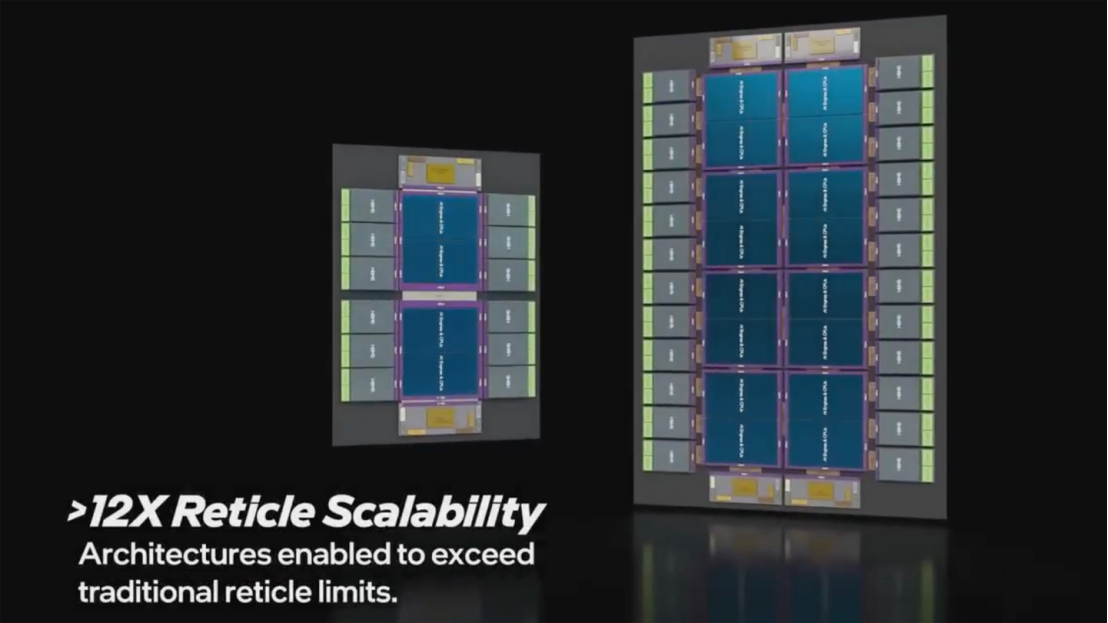

Intel Foundry 在 X 上发布的视频展示了两种概念设计:一种是“中等规模”设计,包含四个计算单元和 12 个 HBM 显存;另一种是“极端规模”设计,包含 16 个计算单元和 24 个 HBM5 显存堆栈,本文重点介绍后者。即使是中等规模的设计,以今天的标准来看也相当先进,但 Intel 现在就可以量产。

至于这种极致封装概念,可能会在本十年末出现,届时英特尔不仅会完善其Foveros Direct 3D封装技术,还会完善其18A和14A生产节点。如果英特尔能在本十年末生产出这种极致封装,将使其与台积电并驾齐驱。台积电也计划推出类似产品,甚至预计至少部分客户会在2027-2028年左右使用其晶圆级集成产品。

在短短几年内将这种极致设计变为现实对英特尔来说是一个巨大的挑战,因为它必须确保组件在安装到主板上时不会变形,即使在极小的公差范围内,也不会因长时间使用后的过热而发生形变。除此之外,英特尔(以及整个行业)还需要学习如何为尺寸堪比智能手机(最大可达 10,296 平方毫米)的巨型处理器提供充足的热量和散热,而这些处理器的封装尺寸还会更大。

随着人工智能革命加速推进至2025年末,业界关注的焦点已从芯片的晶体管数量转向支撑这些晶体管的复杂架构。尽管大规模语言模型(LLM)对计算能力的需求空前高涨,但主要的瓶颈不再仅仅是处理器的速度,而是“内存墙”——即数据在内存和逻辑之间传输速度的物理极限。先进封装技术已成为解决这一危机的关键方案,它从制造过程中的次要步骤转变为半导体创新的核心前沿。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。