HBM4设备,开始生产

韩美半导体公司今日宣布,开始生产其最新的芯片封装设备 TC Bonder 4,该设备专为制造第六代高带宽存储器(HBM4)而设计。

该公司计划于2025年下半年开始批量供应该设备,以配合全球HBM制造商的生产计划。与目前的HBM3E相比,HBM4的性能提升了60%,而功耗仅为HBM3E的70%。该内存芯片最多可堆叠16层,容量也得到了提升,每个DRAM芯片的容量从24千兆位(GB)扩展到32千兆位(GB)。

TC Bonder 在 HBM 制造过程中发挥着关键作用,它通过施加热量和压力来固定堆叠的 DRAM 芯片。全新 TC Bonder 4 的精度显著提升,以满足 HBM4 的严苛规格要求,并升级了软件,提升了易用性。

该公司表示,已经建立了 TC Bonder 4 的量产系统,以确保及时支持全球存储器制造商推出 HBM4,并补充说最新产品将有助于保持其在全球 AI 半导体市场的领先地位。

韩美半导体最近还成立了专门团队“Silver Phoenix”,由 50 多名经验丰富的工程师组成,负责支持 TC Bonder 4 系统的定制、维护和优化。

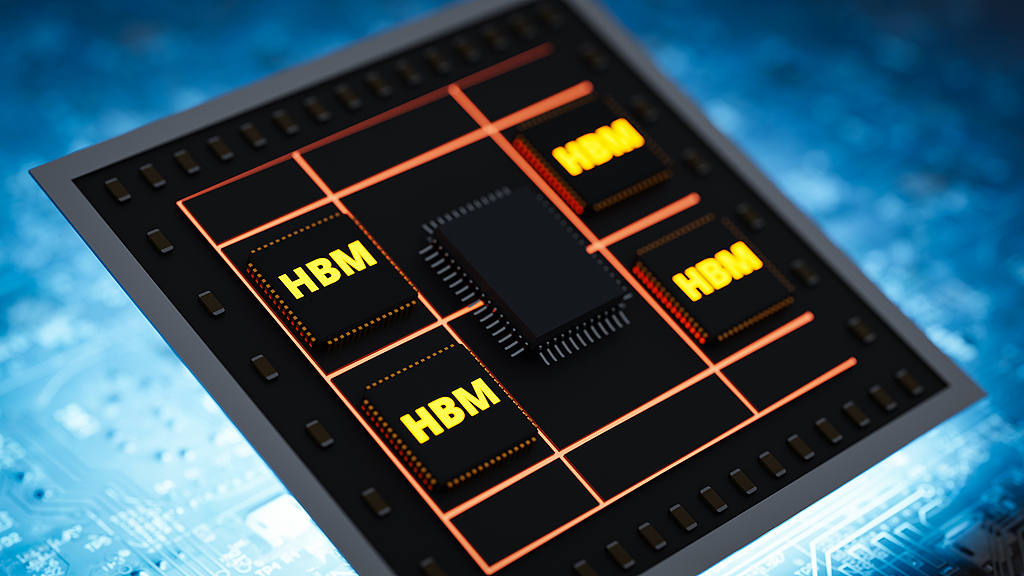

在AI计算时代,HBM有着举足轻重的地位。HBM是通过垂直堆叠多个DRAM芯片,大幅提升数据处理速度,超越传统DRAM的能力,是一种高价值、高性能的产品。HBM的爆火伴随着2023年ChatGPT的出现,它引发了人工智能市场的爆发式增长。自第一代HBM诞生以来,这项技术已发展至第六代,包括HBM2、HBM2E、HBM3、HBM3E和HBM4。

据韩国媒体《DealSite》最新报道,SK海力士已率先向NVIDIA少量供货HBM4产品,标志着该工艺进入正式商用阶段,并有望助力NVIDIA在2025年第四季度按时推出基于Rubin架构的下一代AI加速器。

SK海力士凭借其在HBM制造良率和工艺成熟度方面的领先优势,再次巩固了其在HBM市场的主导地位。此次率先向NVIDIA供货,不仅彰显其技术实力,也可能在未来的HBM4订单中占据绝对优势地位。据业内推测,SK海力士未来或将获得Rubin架构GPU中相当比例的HBM4芯片订单。

在此前的HBM3E竞赛中,SK海力士就曾因高良率与量产能力成为NVIDIA的主要合作伙伴。此次在HBM4上的“首发”合作,无疑会进一步加强双方在AI生态系统中的绑定关系。

而在SK海力士之后,美光科技(Micron)被认为是紧随其后的竞争者,但其HBM4产品面临良率不及预期、产线调配不足等挑战,因此整体供货能力受到限制。这可能影响其短期内成为NVIDIA主要供应商的进展速度。

三星电子方面虽尚未公布HBM4产品的良率数据,但此前已获得AMD对其HBM3E模块的采用,证明其在高带宽内存领域仍具备一定技术竞争力。业内普遍认为,三星凭借其全球影响力和品牌信誉,可能被纳入NVIDIA的HBM4“供应商池”,但能否实现实际出货尚待观察。

HBM4将成为2026年推出的下一代数据中心和AI GPU的核心内存标准。根据KAIST和Terabyte的研究,NVIDIA的Rubin GPU将采用8个HBM4,而高端的Rubin Ultra则会配备16个HBM4。Rubin的GPU裸片面积预计为728平方毫米,单颗裸片功耗800W,其搭载的HBM4内存总容量可达288-384GB,总带宽16-32TB/s,整个芯片功耗2200W。

HBM4标准的主要技术指标令人瞩目:数据传输速率约8Gbps,拥有2048个I/O接口(部分配置可达4096个),单堆栈带宽2.0TB/s,支持12层或16层堆栈,每层裸片容量24Gb,使得每个HBM4模块的容量可达36GB(12层堆栈)或48GB(16层堆栈),每个HBM4模块的功耗为75W。在封装方面,采用Microbump(MR - MUF)技术,并配备直接芯片冷却(D2C)液冷系统。同时,HBM4还采用了定制的基础裸片架构,集成了NMC处理器和LPDDR内存。

AMD的Instinct MI400则更进了一步,计划提供高达432GB的HBM4内存容量,内存带宽可达19.6TB/s。相较于NVIDIA的Rubin,MI400在内存容量和带宽上的提升,显示了AMD在高性能计算领域的强劲竞争力。

HBM4e作为HBM4的增强版本,数据速率提升至10Gbps,单堆栈带宽提高到2.5TB/s,每层裸片容量最大可达32Gb,对应12层或16层堆栈时,内存容量为48GB或64GB,每个HBM4e模块的功耗提升至80W。HBM4e的出现,将为那些对内存性能有极致需求的应用提供更强大的支持。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。