摩尔线程率先支持腾讯混元-A13B模型,完成全功能GPU深度适配

来源:半导纵横发布时间:2025-06-30 11:45

生成海报

摩尔线程宣布,腾讯开源基于专家混合(MoE)架构的大语言模型混元-A13B,摩尔线程团队率先完成该模型在全功能 GPU 的深度适配与高效支持。

据介绍,作为业界首个 13B 级别的 MoE 开源混合推理模型,混元-A13B(Hunyuan-A13B)总参数量达 800 亿,激活参数为 130 亿,不仅在效果上达到了高标准,而且在尺寸上也做到了极致的优化,成功平衡了模型性能与资源占用。

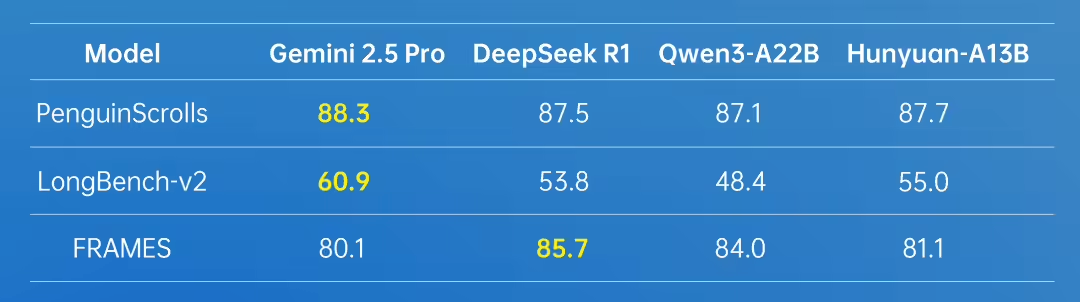

从混元官方发布的 benchmark 测试结果来看:Hunyuan-A13B 在多个代码和数学任务上都取得了最高分数。在 MMLU、MMLU-PRO 等诸多众聚合任务上,Hunyuan-A13B 达到了与 Qwen3-A22B 模型同等的水平,表现出优秀的综合能力。

摩尔线程积极响应开源社区的号召,旨在让更多开发者基于国产全功能 GPU 进行 AI 应用创新。此前,摩尔线程在深度求索 DeepSeek、通义千问 QwQ-32B 和 Qwen3 等模型的发布当日,就成功实现了 Day-0 支持。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。

评论

暂无用户评论