浸入式液体冷却和直接芯片液体冷却有什么区别?

随着机架功耗飙升至前所未有的水平,当今的数据中心正在发生巨大转变。在计算密集型人工智能 (AI) 和高性能计算 (HPC) 应用的推动下,数据中心已迅速从需要使用空气冷却策略冷却 10 到 20 kW 机架转变为使用 NVIDIA 的 Grace Blackwell 超级芯片冷却120 kW机架——而且这还只是针对一个机架!

空气冷却方法根本无法冷却如此多的热量,因此,为新型液体冷却技术铺平了道路,这种技术分为两类:“直接芯片冷却”或“浸入式冷却”。与传统的空气冷却方法不同,这些技术使用液体(水或介电流体)来去除设备中的热量。

随着行业向可持续的 AI 未来迈进,AI 工厂应运而生,以满足日益增长的计算需求,液冷技术有望成为数据中心的关键推动因素,而数据中心已经面临着控制散热、能耗和占用空间的挑战。事实上,随着功率高达 1,200 W 的下一代 GPU 的推出,液冷已迅速从“可有可无”变成了“绝对必要”。随着全球对这项技术的需求不断增加,Mordor Intelligence 等分析师估计,到 2029 年,该技术市场规模将达到 148 亿美元。

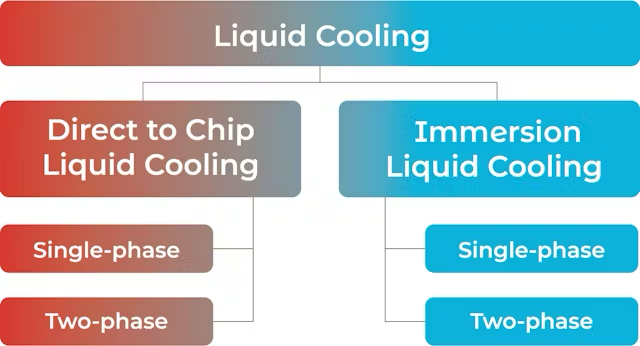

在本文中,我们将解释浸入式和直接芯片液体冷却之间的区别——每种方法都由单相和双相选项组成。然后,我们将概述每种方法在总体可持续性、功耗、易用性、风险、可扩展性和成本方面的优缺点(图 1)。

图1. 市场细分展示了直接芯片和浸入式冷却选项下的变体

浸入式液冷将组件淹没

采用浸入式液体冷却时,服务器和其他组件完全浸没在介电液体中。设备产生的热量被传递到周围的冷却剂中。当加热的冷却剂上升到表面时,它会被送往冷却系统以消散积聚的热量并将其返回到容纳设备的原始水箱中。

浸入式液冷有两种类型:

单相浸没

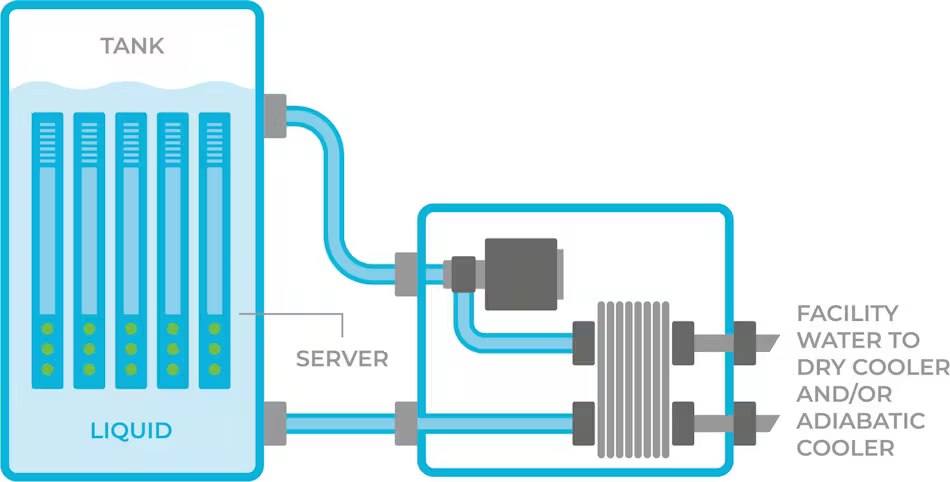

采用这种方法,所有服务器和其他 IT 设备都浸入介电流体中。随着 CPU 或 GPU 升温,流体吸收热量。然后,这种加热的流体被泵送到热交换单元,在那里冷却流体,然后将其送回容纳硬件的箱体(图 2)。

图2.单相浸没:设备浸没在介电液中。

优点:

· 完全的服务器功率吸收,这意味着服务器(GPU、CPU、DIMS 等)发出的所有热量都被收集和冷却。

· 使用绝缘液不会使组件和服务器短路。

缺点:

· 热设计功率(TDP)是有限的,如果GPU的TDP超过700W,单相浸没式散热方式就无法有效冷却硬件。

· 需要大量数据中心基础设施投资,因为现在需要大而重的储罐来容纳设备。这项技术更适合新建数据中心或有空间和能力进行重大改造以容纳储罐的数据中心。它们还应该具有增加重量所需的结构支撑。

· 所有浸入槽中的设备(例如服务器、连接器和 PCB)都需要与介电液体兼容,以免被液体本身损坏。这通常需要选择专用设备或对服务器进行改造。

· 由于服务器上的某些组件(例如光纤连接器)在浸泡时无法工作,因此服务器需要进行机械重新配置。

· 所用液体含有碳氢化合物,具有易燃性。如果数据中心内发生火灾,可能会造成灾难性的损失。

· 服务器的维护很困难,任何所需的服务器维护都需要使用起重机将单个服务器从水箱中“拉”出来,并让其滴水 30 分钟后才能开始维修。

· 任何流体污染(例如水)都需要排出并清理水箱,这可能会导致一整天的停机。

两相浸没

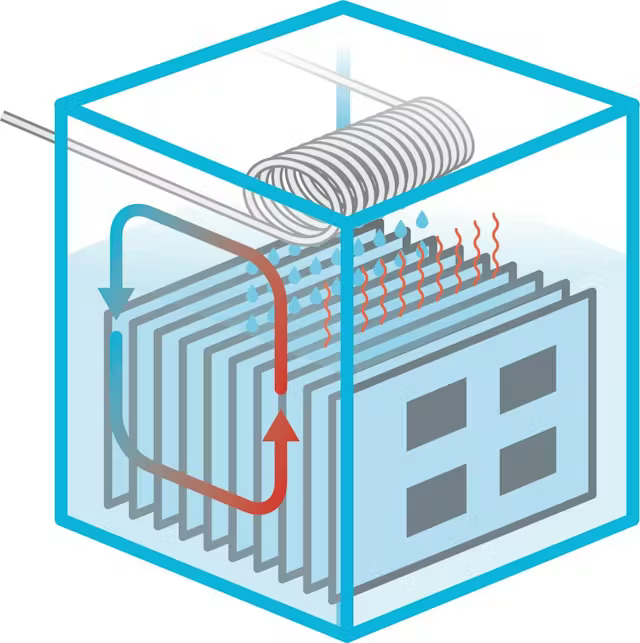

与单相浸没类似,这种方法也涉及将服务器和 IT 设备完全浸没在介电流体中。但是,随着电路板上的组件升温,流体沸腾,产生的蒸汽从液体上升到水箱顶部。水箱顶部有一个管道网络,冷却水从管道中流出。水箱中的蒸汽接触到冷管道后凝结成液体滴回水箱;管道中的水被加热,通过加热的水将热量带到设施中,并从数据中心排出(图 3)。

图3.两相浸没:服务器设备浸没在电介质液体中。

优点:

· 完全的服务器功率吸收,这意味着服务器(GPU、CPU、DIMS 等)发出的所有热量都被收集并冷却。

· 可以支持非常高的 TDP。

· 使用绝缘液不会使组件和服务器短路。

缺点:

· 所有浸入槽中的设备(例如服务器、连接器和 PCB)都需要与电介质液体兼容,以免被液体本身损坏。这通常需要选择专用设备或对服务器进行改造。

· 作为流体沸腾的一部分,剧烈的空化过程会对 IT 部件、PCB 和线路造成损坏。

· 需要大量的数据中心基础设施投资,因为现在需要大型、重型的罐体来容纳设备,并且需要额外的支撑来承载重量。

· 由于罐体和设备浸泡在液体中,维护过程中通常需要使用起重机进行较长的停机时间。

· 每次打开储罐进行维护时,含有 PFAS(全氟和多氟烷基物质)的蒸汽就会释放到环境中,导致每年 10% 的液体损失(数百升),并且大量 PFAS 蒸汽被释放到大气中。

直接芯片液体冷却的工作原理

与将整个服务器和其他 IT 设备浸没在液体中的浸没式液体冷却不同,直接芯片冷却工艺将冷却液带到直接放置在高热通量(例如 CPU 和 GPU)顶部的冷板上。这种液体会带走组件中的热量。它包含在冷板中,永远不会接触芯片或服务器设备。

人们普遍认为,直接芯片冷却方法比其他类型的冷却方法更快、更高效,因为它可以针对产生大部分热量的区域进行冷却。事实上,在最近的Omdia 分析师峰会上,他们的分析师表示:“随着机架尺寸超过 50kW,直接芯片冷却技术将占据主导地位。”

由于冷板主要位于高热通量组件上,因此需要服务器风扇来去除低热通量组件上的多余热量。

直接芯片液体冷却有两种类型:

单相直接芯片冷却

这种液体冷却方法使用水作为冷却板中的冷却剂。水始终保持液态,并且该方法带走热量的能力取决于水流量——热量越高,所需的水流量就越大。

优点:

· 具有高流量的冷水,可支持高TDP组件的冷却。

· 数据中心基础设施和服务器很像空气冷却;需要进行微小的改动来添加冷板冷却。

缺点:

· 由于使用水代替介电流体,因此泄漏风险很大且代价高昂。水泄漏不仅会毁掉价值 30 万美元的服务器,还会导致腐蚀、发霉、残留物、生物生长和其他环境影响。

· 需要投资更大的管道、浴缸和连接器,以防流量和压力增加时漏水。水流还需要更大、耗电更大的泵来持续输送水通过系统。

两相直接芯片冷却

与使用水的单相直接芯片方法不同,双相方法利用对 IT 设备 100% 安全的介电液体。来自 GPU 和 CPU 的热量使介电液体在低温下沸腾,利用非常有效的相变物理现象吸收热量,使芯片保持恒定温度。这类似于沸水如何使意大利面锅底保持在 100°C,只是温度较低(图 4)。

图4. ZutaCore 的 HyperCool 冷板使用电介质液体根据需要散热。

将介电流体的状态从液体变为气体然后再变回液体的过程是在完全闭环系统中完成的。当冷板内的液体沸腾时,即使热量增加 3 倍(即 GPU 和 CPU 更热),冷板中的液体也永远不会超过沸腾温度。因此,该技术具有高度可扩展性,可用于未来冷却更高功率的芯片。

这与单相直接芯片冷却方法形成鲜明对比,后者依靠水流(而且水量很大)来冷却芯片。从这个角度来看,使用双相直接芯片冷却技术的 100 kW 机架将使用不到 4 加仑的介电流体,而浸没式冷却则需要每机架 100 加仑以上的介电流体。

优点:

· 无水直接芯片液体冷却:介电流体 100% 安全,即使发生泄漏也不会损坏服务器。

· 增加计算密度:每个机架允许>150 kW。

· 面向未来:每个芯片高达 2500 W 甚至更高。

· 与风冷相比可节省高达80%的功耗。

· 由于液体保持恒定的温度,服务器产生的热量可以被收集起来用于热再利用应用,例如加热相邻的办公室、数据中心的其他部分,甚至附近的学校和办公楼。

· 几乎不需要对数据中心基础设施进行任何改变,从而降低前期投资成本,并且安装过程简单。

· 维护要求低:介电液无需更换,与浸泡不同,在服务器和机架维护期间,介电液不会释放到大气中。所用液体的臭氧消耗潜能值 (ODP) 为 0,全球变暖潜能值 (GWP) 极低。

· 即使下一代 GPU 的发热量增加,仍可保持 1U 服务器外形尺寸。

缺点:

· 液冷仅用于散发 CPU/GPU 的热量。其他组件(如内存、I/O 等)仍需要风冷。

条条大路通“液体冷却”

人工智能的未来发展在很大程度上取决于数据中心容量的扩展能力,这将使这些设施内部的热量达到前所未有的水平。正如本文所述,现在有许多不同类型的液冷技术可用于帮助消除这种热量,但每种技术都有各自的优缺点。

全球各地的数据中心和超大规模企业需要决定哪种解决方案更适合他们。这应该在成本、功耗、易用性、可扩展性和可持续性方面进行权衡。只有这样,行业才能实现真正的 AI 可持续性。

本文转自媒体报道或网络平台,系作者个人立场或观点。我方转载仅为分享,不代表我方赞成或认同。若来源标注错误或侵犯了您的合法权益,请及时联系客服,我们作为中立的平台服务者将及时更正、删除或依法处理。